Estudantes criam programa que converte Libras em texto

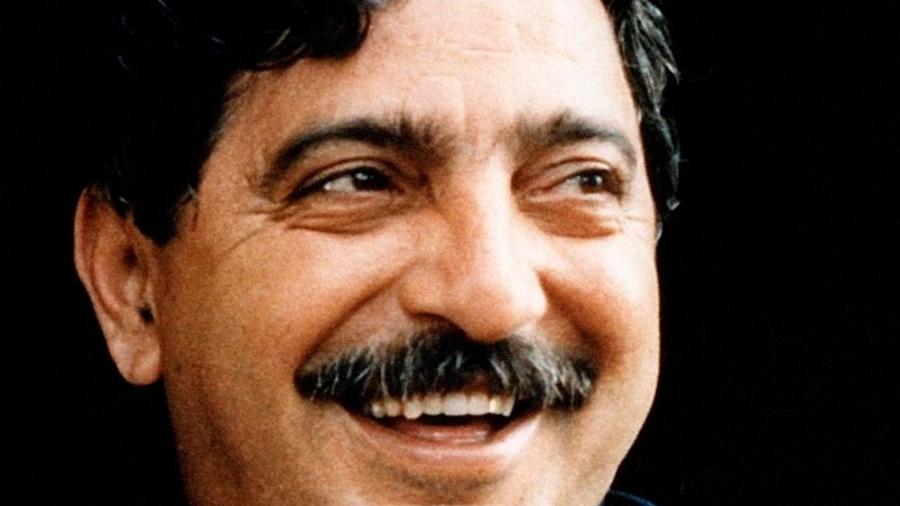

O jovem Luciano dos Anjos Oliveira, de 18 anos, sempre teve vontade de desenvolver softwares para ajudar as pessoas. Esse interesse está relacionado à sua própria vivência e às dificuldades que enfrenta para se comunicar. "Nasci com lábio leporino e isso afeta minha fala. Por conta disso, percebi a dificuldade que pessoas com deficiência - seja ela cognitiva ou comunicativa - enfrentam para viver em sociedade. Por isso, acredito na inclusão social de todos", explica.

Essa foi uma das principais razões que o levaram a entrar no curso de Desenvolvimento de Sistemas da Escola Técnica Estadual (Etec) Lauro Gomes, de São Bernardo do Campo, no ABC Paulista. Segundo o site do processo seletivo das Etecs, essa formação prepara profissionais para projetar e construir sistemas de informação, além de trabalhar com ambientes de desenvolvimento e linguagens de programação.

Quando chegou a hora de fazer o trabalho de conclusão de curso (TCC), Luciano viu aí a chance de colocar seu propósito em prática. Junto com os colegas de classe Vinícius Luciano Navarrete da Silva e Fabrício Holanda de Almeida, ele desenvolveu o Software de Reconhecimento de Sinais, que converte a Língua Brasileira de Sinais (Libras) em texto.

Tecnologia inovadora

O grupo usou sistemas de machine learning (ou aprendizado de máquina) e uma biblioteca de código aberto desenvolvido pelo Google chamada MediaPipe. A partir daí, eles desenvolveram uma aplicação capaz de reconhecer gestos e sinais de mão, rosto e corpo e relacioná-los com a palavra correspondente em texto.

Para isso, foi necessário processar mais de 20 mil vídeos, entre alguns que foram gravados pelos próprios estudantes e outros do Youtube. Os movimentos presentes nos vídeos foram convertidos para coordenadas, que então foram usadas por eles para construir um modelo de rede neural.

Segundo Luciano, é assim que o software é capaz de identificar movimentos por meio de pontos de referência e gerar uma palavra a partir deles. Hoje, o programa já conta com uma biblioteca de 100 sinais reconhecíveis.

O processo tem sido longo, e o grupo chegou a trabalhar 18 horas por dia nas semanas que antecederam a entrega do TCC. "Começamos a pensar no projeto em 2019, e somente em 2020 iniciamos a programação", conta o aluno, acrescentando que o trabalho ainda não está finalizado.

Como se o desafio de trabalhar com tecnologias novas não fosse grande o bastante, a pandemia representou um obstáculo ainda maior. "Esse modelo de rede neural exige muito tempo para ser construído, e tivemos grandes dificuldades porque isso exige um computador potente e focado em inteligência artificial, algo que só eu tinha no grupo", explica Luciano. Por isso, ele ficou responsável pelo desenvolvimento do software enquanto o restante da equipe cuidou da parte de análise e design.

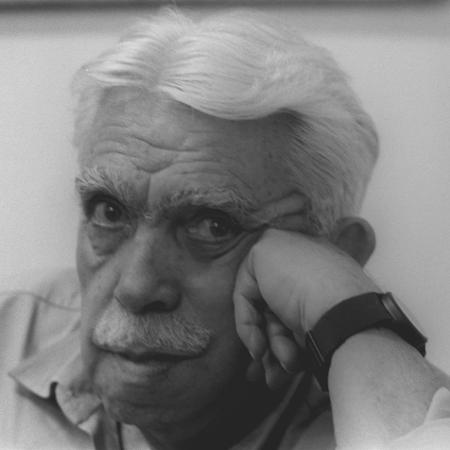

Os alunos também contaram com o apoio de orientadores. Um deles, o professor Cleiton Fabiano Patricio, explica que o projeto é baseado em uma tecnologia não apenas complexa, mas ainda muito nova. "Trabalhar com programação de inteligência artificial exige muita dedicação e foco para que se possa entender toda a arquitetura dela", diz.

O trabalho se destacou na escola e fora dela: ficou em primeiro lugar na feira 1º Feira Científica STEAM (Ciência, Tecnologia, Engenharia, Arte e Matemática) do Grande ABC e em nono na votação popular da 19ª Feira Brasileira de Ciências e Engenharia - Febrace (para a qual o grupo fez o vídeo abaixo). Eles também receberam convite para participar de outras feiras ainda este ano.

Próximos os

Hoje, o grupo está trabalhando para ampliar a base de dados e aprimorar a programação dos sinais, além de incluir a tradução automática de Libras para texto e áudio em português e em outros idiomas.

Eles também pretendem criar um aplicativo para que a solução esteja disponível para ser usada pelo público no dia a dia. "Conseguimos alcançar muitas pessoas com a nossa proposta, mas ainda queremos chegar mais longe", defende Luciano. "Muita gente não tem conhecimento de Libras, e falta ibilidade para os surdos e mudos em hospitais, metrôs e nas empresas. Com esse projeto, será possível levar mais facilidade de comunicação a todos esses lugares".

ID: {{comments.info.id}}

URL: {{comments.info.url}}

Ocorreu um erro ao carregar os comentários.

Por favor, tente novamente mais tarde.

{{comments.total}} Comentário

{{comments.total}} Comentários

Seja o primeiro a comentar

Essa discussão está encerrada

Não é possivel enviar novos comentários.

Essa área é exclusiva para você, , ler e comentar.

Só s do UOL podem comentar

Ainda não é ? Assine já.

Se você já é do UOL, faça seu .

O autor da mensagem, e não o UOL, é o responsável pelo comentário. Reserve um tempo para ler as Regras de Uso para comentários.